强化学习(Reinforcement Learning, RL)是人工智能领域中一个充满魅力的研究方向。它通过智能体与环境交互来学习如何做出决策,从而最大化某种累积奖励。这种学习方式与人类及动物的学习过程有着相似之处,例如在游戏、机器人控制、推荐系统等领域展现了广泛的应用前景。

1. 环境与智能体

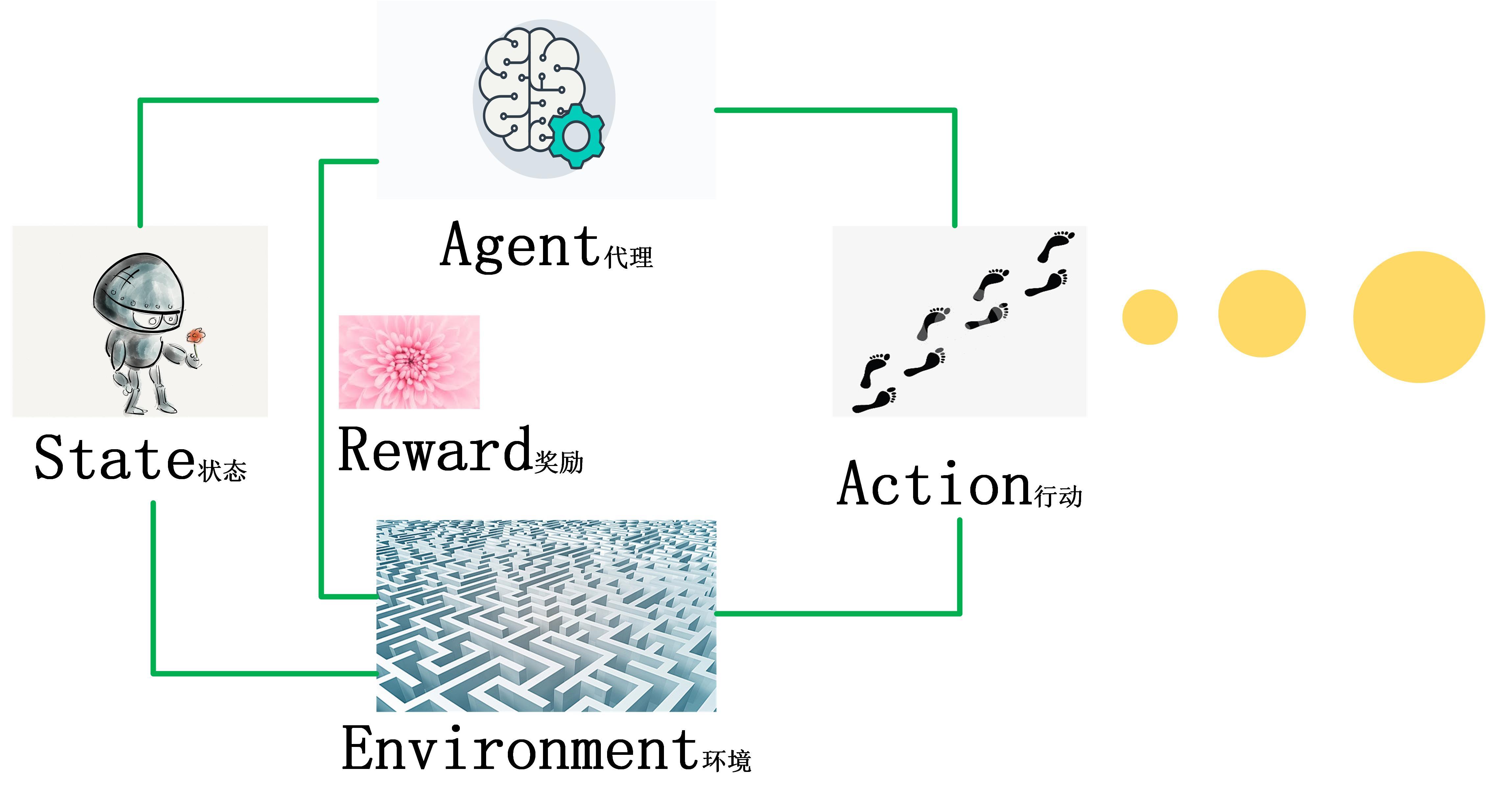

在强化学习中,智能体(Agent)是指能够执行动作并从中获得反馈的主体,而环境(Environment)则是智能体所处的世界。智能体与环境之间不断进行信息交换,这种交互构成了强化学习的核心过程。

2. 状态与动作

状态(State)表示智能体在环境中的当前情况,它包含了所有有助于决策的相关信息;动作(Action)则是智能体能够采取的行为。状态和动作共同构成了智能体与环境之间的交互链。

3. 奖励信号

奖励信号(Reward Signal)是环境给予智能体的反馈,用于指导智能体的学习过程。奖励可以是即时的,也可以是延迟的,这取决于任务的具体要求。合理的奖励设计对于智能体学习有效的策略至关重要。

1. Q-learning算法

Q-learning是一种基于值函数的离线算法,它通过表查找的方式记录每个状态-动作对的期望奖励。其核心思想是利用贝尔曼方程来更新Q值,并逐步逼近最优策略。Q-learning存在样本效率较低的问题,因为它需要遍历所有的状态-动作对才能收敛。

2. SARSA算法

SARSA(State-Action-Reward-State-Action)是一种在线算法,它直接使用当前状态-动作对的Q值来进行策略选择。与Q-learning相比,SARSA具有更好的探索能力,但在某些情况下可能会陷入局部最优解。

3. 动态规划方法

动态规划方法包括值迭代和策略迭代两种。值迭代通过迭代计算每个状态的值函数,直到收敛于最优值函数;策略迭代则先固定一个策略,然后根据该策略计算出新的值函数,再更新策略,重复此过程直至策略不再发生变化。

4. 深度强化学习

随着深度学习技术的发展,深度强化学习逐渐成为研究热点。通过将神经网络应用于强化学习中,可以有效地处理高维连续状态空间和复杂环境。常用的深度强化学习算法包括深度Q网络(Deep Q-Network, DQN)、策略梯度方法等。

1. 游戏

强化学习在游戏领域有着广泛应用,例如AlphaGo就是通过强化学习战胜了围棋世界冠军。它通过对大量棋局的训练,学会了评估棋盘状态并选择最佳落子位置。在其他策略型游戏中,如星际争霸、DOTA等,强化学习也展现出了强大的潜力。

2. 机器人控制

机器人控制是强化学习的一个重要应用场景。通过让机器人与环境进行交互,可以训练出能够完成特定任务的机器人。例如,在工业生产线上,机器人可以通过强化学习学会如何精确地搬运货物;在家庭环境中,机器人可以学会如何清洁房间等。

3. 推荐系统

推荐系统旨在为用户提供个性化的内容推荐,从而提高用户体验。强化学习可以通过观察用户的反馈来调整推荐策略,使用户获得更符合自己喜好的内容。例如,电商平台可以根据用户的浏览历史和购买行为,为其推荐可能感兴趣的商品。

尽管强化学习取得了许多令人瞩目的成果,但仍面临着诸多挑战。强化学习算法通常需要大量的数据和计算资源才能达到较好的效果,这对实际应用提出了较高的要求。如何设计合适的奖励函数也是一个难题,因为不合理的奖励函数可能导致智能体学习到错误的行为。强化学习还面临着样本效率低下的问题,尤其是在面对复杂多变的环境时。

为了克服这些挑战,研究人员正在积极探索新的算法和技术。例如,结合迁移学习和元学习的方法,可以在不同任务之间共享知识,提高模型的泛化能力;通过引入好奇心机制,可以使智能体更好地探索环境,从而加速学习进程。随着硬件技术的进步,大规模并行计算也为强化学习的研究提供了更多可能性。

标签: 从基础原理到实际案例的全面解析、 探索强化学习、本文地址: https://www.2drx.com/hlwzxwz/17c52ac52ded859b1409.html

上一篇:深度解读强化学习理论实践与未来发展方向...